| |

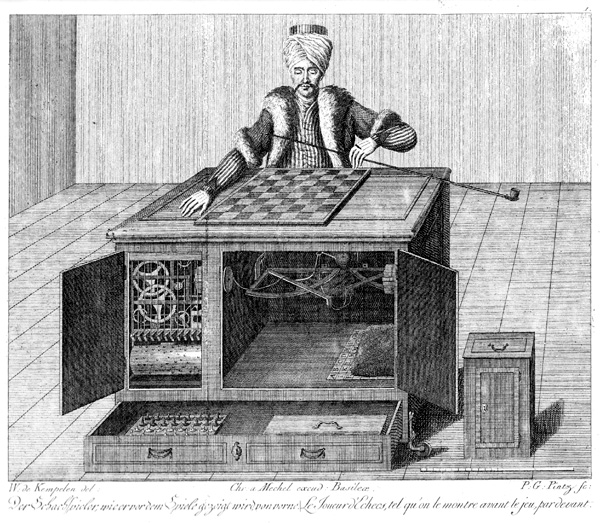

| Mechanischer Schachtürke, Kupferstich von Windisch |

Zusätzlich zu den Einlieferungen aus den verschiedenen Workflows der Einrichtungen (Digitalisierung, wissenschaftliche Publikationsservices mit born-digital-Dokumenten, digitale Foto- und Mediensammlungen, Archive für medizinische Daten u.v.a.m.) gibt es oft Anforderungen der verschiedenen Fachabteilungen, die Inhalte des eLZA zu aktualisieren oder mit zusätzlichen Daten anzureichern ("AIP Update").

Auch wenn manuelle Prozesse für Mitarbeiter der Führungsebene und der Arbeitsebene gleichermaßen verlockend scheinen, sind sie doch zeitaufwändig und durch die menschliche Komponente auch fehleranfällig. Menschen sind jedoch gut darin, intellektuelle Leistungen zu vollbringen, denken und Schlüsse zu ziehen; weniger gut sind sie darin, monotone Prozesse in immer gleichmäßiger Qualität auszuführen.

Grundsätzlich kann man fast jeden Prozess der Langzeitarchivierung automatisieren. Nur Prozesse, die genau einmal während der Lebensdauer des eLZA auftreten, sind aus Effizienzgründen davon ausgenommen. Im Fall der Retrodigitalisierung (Scannen historischer Schriften u. ä.) beginnt diese Automatisierung oft schon bei der Erstellung des Archivmaterials, bei anderen Prozessen kann die Automatisierung frühestens beim Ingest ansetzen. Voraussetzung ist nur, dass sowohl Nutzdaten als auch Metadaten in maschinenlesbarer Form (gern geeignete XML-Formate) vorliegen. Sie setzt sich fort in Updates an den Archival Information Packages (AIP) und an den fortwährend nötigen Risikobewertungen und Formatwandlungen zur Bestandserhaltung und, sofern man nicht gerade "dark archive" betreibt, der Auslieferung an den Endnutzer.

Wichtig ist in jedem Fall, dass das Teilproblem klein und überschaubar ist, die Anforderungen klar feststehen und die Schnittstellen zu anderen Teilen des Gesamtsystems gut durchdacht und -definiert sind. So ist sichergestellt, dass die Komplexität niedrig gehalten wird und der Entwicklungsaufwand überschaubar bleibt.

Außerdem sollte die Automatisierung von Anfang an Teil der konzeptionellen Überlegungen sein und in Entscheidungen zum System und den verfügbaren Schnittstellen einfließen, um das Archivsystem geeignet von außen ansteuern zu können. Nur so ist sichergestellt, dass alle Schritte der Einlieferung und Bewahrungsaktionen ohne menschliches Eingreifen ablaufen können.

Entscheidet man sich für die Automatisierung, erhält man nach einem leicht erhöhten initialen Aufwand ein stabiles System, das in gleichbleibender Qualität große Datenmengen verarbeitet. Sicher ein Tausch, der die Mühe lohnt.

Keine Kommentare:

Kommentar veröffentlichen